特征值特征向量求原矩阵的过程可以通过特征分解来实现。对于一个给定的方阵A,存在特征值λ和相应的特征向量v,使得Av = λv,那么矩阵A可以用它的特征值和特征向量进行重构。来说,设A的特征值为λ₁, λ₂, ..., λₙ,特征向量为v₁, v₂, ..., vₙ,则可以通过构造对角矩阵D(对角线上为特征值)和特征向量矩阵P(由特征向量构成的矩阵)来表示A为A = PDP⁻¹。这个过程的关键在于特征向量的线性独立性,只有当特征向量线性独立时,才能确保P是可逆的,从而成功重构原矩阵。

一、特征值与特征向量的基本概念

特征值和特征向量是线性代数中的重要概念。特征值是一个标量,表示在特定变换下向量的伸缩因子;而特征向量则是该变换不改变方向的向量。在许多应用中,特征值和特征向量可以帮助我们简化复杂的矩阵运算,尤其是在大规模数据分析和机器学习等领域。

二、特征分解的步骤

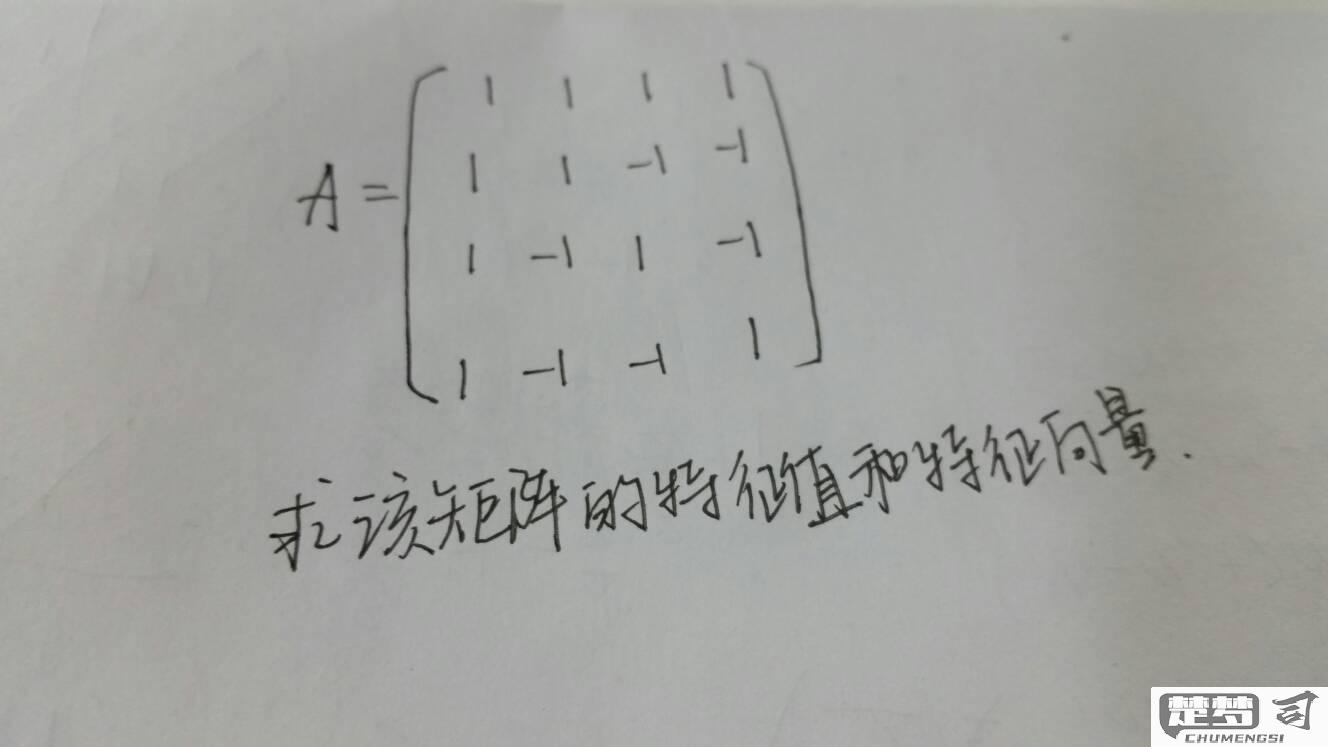

特征分解的步骤主要包括:首先计算矩阵的特征值,通过求解特征方程det(A - λI) = 0得到;接着,求出对应的特征向量,通过解线性方程组(A - λI)v = 0得到;构造对角矩阵D和特征向量矩阵P,利用公式A = PDP⁻¹重构原矩阵。在这个过程中,确保特征向量的线性独立性是成功重构的关键。

三、特征分解的应用

特征分解在各个领域都有广泛的应用,例如在图像处理中的主成分分析(PCA)、在量子力学中的状态描述、在网络分析中的谱聚类等。通过特征分解,可以有效降低数据的维度,提取主要特征,从而简化计算和分析过程。

相关问答FAQs

问:什么情况下可以使用特征值特征向量来求原矩阵?

答:特征值特征向量适用于任何方阵,尤其是当该矩阵是可对角化时,即存在足够数量的线性独立特征向量时,才能使用特征分解来求原矩阵。

问:如何判断特征向量是否线性独立?

答:可以通过构造特征向量矩阵P,计算其行列式。行列式不为零,则说明特征向量线性独立;否则,特征向量不线性独立。

问:特征分解与奇异值分解有什么区别?

答:特征分解主要应用于方阵,适用于对称或可对角化的矩阵;而奇异值分解适用于任意矩阵,可以处理非方阵,通常用于数据降维和信号处理。