已知特征值和特征向量可以通过特征值分解来求出矩阵。步骤如下:1. 设特征值为λ,特征向量为v,构建方程(A - λI)v = 0。2. 通过求解上述方程可以得到矩阵A的特征空间。3. 通过组合已知的特征向量,利用特征值,可以重构出矩阵A。特征向量是线性独立的,可以通过这些向量构造出一个对角矩阵D和一个可逆矩阵P,从而得出A = PDP^(-1)。关键在于特征向量的线性独立性与矩阵的可对角化性。

一、特征值与特征向量的基本概念

特征值与特征向量是线性代数中的重要概念。对于一个n×n的矩阵A,存在非零向量v使得Av = λv成立,则λ称为矩阵A的特征值,v称为对应的特征向量。特征值和特征向量在许多应用中具有重要意义,例如在机器学习、物理学等领域中,能够帮助我们理解系统的性质。

二、特征值分解的过程

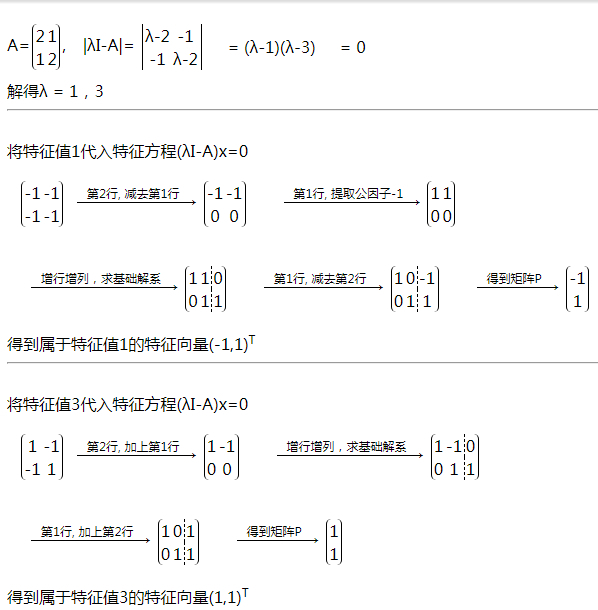

特征值分解是将矩阵A表示为其特征值和特征向量的乘积。计算特征值λ,方法是求解特征方程|A - λI| = 0。得到特征值后,输入到(A - λI)v = 0中求解特征向量v。假设我们得到了k个特征值和对应的特征向量,若这些特征向量线性独立,则可以构造出矩阵P和对角矩阵D,从而表示A = PDP^(-1)。

三、特征值和特征向量的应用

特征值和特征向量的计算在数据降维、图像处理以及量子力学等领域有广泛应用。在PCA(主成分分析)中,特征值和特征向量能帮助我们识别数据中的重要方向。特征值在稳定性分析中也起到关键作用,能够判断系统的稳定性和动态特性。

FAQs

问:如何判断特征向量是否线性独立?

答:可以通过计算特征向量构成的矩阵的行列式,行列式不为零,则这些特征向量线性独立。

问:特征值分解的条件是什么?

答:矩阵需要是方阵,并且在某些情况下需要是对称的,只有这样才能保证其特征值是实数且特征向量是线性独立的。

问:如何处理特征值为零的情况?

答:特征值为零意味着矩阵是奇异的,这时可以使用广义特征向量或其他方法来处理,例如奇异值分解(SVD)。